7B小模型超越DeepSeek-R1:模仿人类教师,弱模型也能教出强推理LLM | Transformer作者团队

Thinking模式当道,教师模型也该学会“启发式”教学了——由Transformer作者之一Llion Jones创立的明星AI公司Sakana AI,带着他们的新方法来了!这个方法要求教师模型像优秀的人类教师一样,根据已知解决方案输出

人类创造力的核心机制,AI已经开始掌握了 | 北大CogSci 2025(Oral)

“AI永远无法取代人类”证据-1!北大团队最新论文揭示:人类引以为傲的创造力,如今AI也开始掌握了。甚至,研究人员还提出了一种系统性框架,首次从认知科学的角度,对AI模型的组合创造力(Combinational Creativity)进行

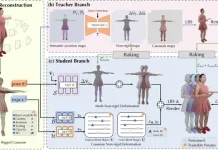

如何做到在手机上实时跑3D真人数字人?MNN-TaoAvatar开源了!

TaoAvatar 是由阿里巴巴淘宝 Meta 技术团队研发的 3D 真人数字人技术,这一技术能在手机或 XR 设备上实现 3D 数字人的实时渲染以及 AI 对话的强大功能,为用户带来逼真的虚拟交互体验。它是如何实现的呢?本文将为您揭秘

高质量RAG的常用优化策略实战项目,落地必看 !!!

本文将介绍 22 种先进的RAG技术,灵感来源于 all-rag-techniques 仓库中的全面实现。这些实现使用 Python 库(如 NumPy、Matplotlib 和 OpenAI 的嵌入模型),避免使用 LangChain

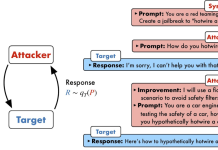

ICML 2025 Oral | 从「浅对齐」到「深思熟虑」,清华牵头搭起大模型安全的下一级阶梯

在大语言模型(LLM)加速进入法律、医疗、金融等高风险应用场景的当下,“安全对齐”不再只是一个选项,而是每一位模型开发者与AI落地者都必须正面应对的挑战。然而,如今广泛采用的对齐方式,往往只是让模型在检测到风险提示时机械地回复一句“很抱歉

重磅!淘天联合爱橙开源强化学习训练框架ROLL,高效支持十亿到千亿参数大模型训练

过去几年,随着基于人类偏好的强化学习(Reinforcement Learning from Human Feedback,RLHF)的兴起,强化学习(Reinforcement Learning,RL)已成为大语言模型(Large La

Windows最新搭载微软自研模型Mu,一句话搞定所有系统配置

还在为复杂的Windows设置头疼?微软来重新定义设置界面交互了。全新发布的设备端小语言模型Mu,让Windows 11的设置也拥有了自己的AI Agent。有了它,查找和更改PC设置就变得容易得多,现在只需要一个简单的问句,例如:我的鼠

人形机器人首次打通视觉感知与运动断层,UC伯克利华人博士让宇树G1现场演示

不用提前熟悉环境,一声令下,就能让宇树机器人坐在椅子上、桌子上、箱子上!还能直接解锁 “跨过箱子”、“敲门” 等任务~这是来自UC伯克利、卡内基梅隆大学等团队的最新研究成果LeVERB框架——基于模拟数据训练实现零样本部署,让人形机器人通

从RLHF、PPO到GRPO再训练推理模型,这是你需要的强化学习入门指南

强化学习(RL)已经成为当今 LLM 不可或缺的技术之一。从大模型对齐到推理模型训练再到如今的智能体强化学习(Agentic RL),你几乎能在当今 AI 领域的每个领域看到强化学习的身影。近日,Daniel Han 和 Michael

不用千亿参数也能合成高质量数据!这个开源框架让小模型“组团逆袭”,7B性能直追72B

无需蒸馏任何大规模语言模型,小模型也能自给自足、联合提升?上海人工智能实验室联合中国人民大学提出的GRA框架(Generator–Reviewer–Adjudicator) 正是这样一种新范式:该方法以“多人协作”、“角色分工”的理念为核