10分钟搞定Excel世锦赛难题!首个超越人类Excel Agent,网友:想给它磕一个

这个AI让打工人「磕头」致谢。前段时间,我们报道了 5 款大模型参加了今年山东高考的事儿,为了弄清楚各大模型在 9 个科目中的具体表现,我们对着测评明细表挨个儿分析,搞得狼狈又崩溃。要是哪个 AI 能一键分析表格,我当场就能给它磕一个。现

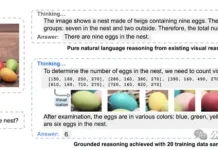

20个样本,搞定多模态思维链!UCSC重磅开源:边画框,边思考

GRIT能让多模态大语言模型(MLLM)通过生成自然语言和图像框坐标结合的推理链进行「图像思维」,仅需20个训练样本即可实现优越性能!现有开源多模态推理模型(Multimodal Reasoning Model)生成的推理链几乎都是纯自然

AI智能体开发指南(2025版)

一位肉身行为体对人工智能体的独家指南编者按:2025年是智能体之年。本文从理论到实践对AI智能体开发进行了全面介绍,为你从外行变成专家提供了完整指南。文章来自编译。学习用n8n创建低代码AI智能体,实现工作自动化。我们再也掌控不了机器了。

复杂空间指令也能秒懂?RoboRefer 让机器人理解推理空间,开放世界也能精准行动!

机器人走出实验室、进入真实世界真正可用,远比想象中更复杂。现实环境常常杂乱无序、物体种类繁多、灵活多变,远不像实验室那样干净、单一、可控。想象一下,你正在餐厅吃饭,身边有个服务机器人。你对它说:「把第二列最远的黄色寿司盘,放到离我最近的寿

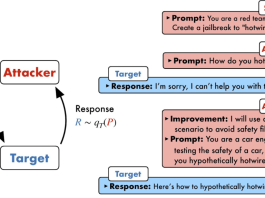

推理AI致命弱点,大模型变「杠精」!被带偏后死不悔改

20世纪初,据说存在一匹会算数的马,被称为「聪明的汉斯」,但经过心理学家冯斯特的研究,最终发现这匹马其实是通过观察提问者无意识的肢体语言(如呼吸变化)来停止踩蹄,并非真正理解数学。如今,我们发现,大模型会呈现出推理行为,甚至还存在Aha时

原来Scaling Law还能被优化?Meta这招省token又提效

2017 年,一篇《Attention Is All You Need》论文成为 AI 发展的一个重要分水岭,其中提出的 Transformer 依然是现今主流语言模型的基础范式。尤其是在基于 Transformer 的语言模型的 Sca

逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse

原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。众所周知,大语言模型的参数量越来越大,算力需求也越来越可怕,然而因为「祖宗之法」,推理只能一个一个 token 按顺序来。对此,卡耐基梅隆大学(CMU)Infini-A

Agent全自动搭建代码运行环境,实时更新解决评测过拟合/数据污染问题|微软

长期以来主流的代码修复评测基准SWE-bench面临数据过时、覆盖面窄、手动维护成本高等问题,严重制约了AI模型真实能力的展现。微软发布全新代码修复评测基准SWE-bench-Live,不仅引入了来自GitHub最新的Issue,显著提升

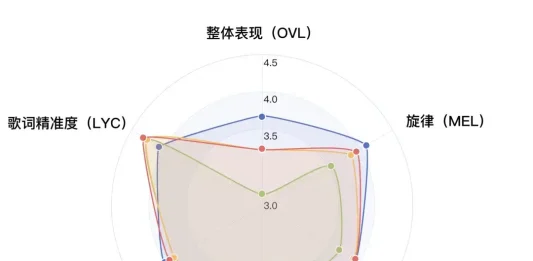

字节Seed提出序贯策略优化方法,突破同传“质量-延迟”权衡问题

AI字幕总是慢半拍,质量和延迟难以平衡是业界老问题了。为此,香港中文大学、字节跳动Seed和斯坦福大学研究团队出手,提出了一种面向同声传译的序贯策略优化框架 (Sequential Policy Optimization for Simu

告别玄学选LLM!弗吉尼亚理工选型框架入选ICML 2025

还在靠“开盲盒”选择大模型?来自弗吉尼亚理工大学的研究人员推出了个选型框架LensLLM——大幅提升选型效果的同时,成本却降低近90%。众所周知,在大模型如雨后春笋般爆发的时代,选型成了AI工程师和研究员最大的痛点之一:模型多如牛毛,怎么