单GPU搞定高清长视频生成,效率×10!引入Mamba机制突破DiT瓶颈 | 普林斯顿&Meta

视频生成模型太贵太慢怎么办?普林斯顿大学和Meta联合推出的新框架LinGen,以MATE线性复杂度块取代传统自注意力,将视频生成从像素数的平方复杂度压到线性复杂度,使单张GPU就能在分钟级长度下生成高质量视频,大幅提高了模型的可扩展性和

AI App 2024年赚了12亿美元,谁在给AI氪金?

文章摘要2024年全球AI移动应用收入达12亿美元,同比猛增179%。图片/视频生成应用主要由亚洲市场驱动,细分需求兴起;ChatBot领域ChatGPT占据主导,但套壳产品表现意外强劲,用户分层明显(高知男性与年轻女性为主)。AI赋能生

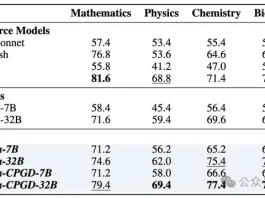

DPO与GRPO谁更胜一筹?港中文、北大等联合发布首个系统性对比研究

近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。如今,这股 RL 的浪潮也涌向了图像生成领域。当

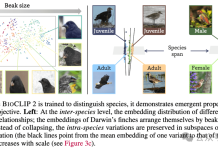

AI一眼认出95万物种,还能分辨雄雌老幼,2亿生物图像炼成“生命视觉”大模型

让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。而更令人惊喜的是,即使在训练过程中没有相应监督信号,

田渊栋:连续思维链效率更高,可同时编码多个路径,“叠加态”式并行搜索

AI也有量子叠加态了?连续思维链的并行搜索类似于量子叠加,比离散型思维链更具优势。这是AI大牛田渊栋团队的最新研究成果。传统LLM通过生成 “思维token”(如文本形式的中间步骤)进行推理(即离散思维链),但在处理复杂任务(如判断有向图

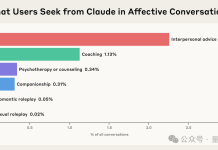

Anthropic最新研究:Claude正悄悄进化为“情绪价值大师”

你有没有试过,深夜心情低落时,对着AI倾诉?Anthropic最新研究发现,越来越多成年人正把AI当作情感陪伴。而Claude,正在悄悄成为那个“温柔倾听”的存在。△Claude中不同情感类互动类型及其占比研究显示,人们在面临更深层次的情

AI科学家组团搞科研,爆肝万字报告震惊医学家!Nature独刊揭秘细节

谷歌、斯坦福等陆续推出「AI科学家」,协助人类科学家推动科研范式革新。科学家亲身试用后或震惊其洞察之深,或质疑其缺乏灵感与人性温度,AI能代替人类思考吗?斯坦福大学的病理学家Thomas Montine在4月的某个周日早晨,按照「惯例」举

多智能体到底该不该建?Anthropic、Cognition 与 LangChain 的三种解法

大模型驱动的 AI 智能体(Agent)架构最近讨论的很激烈,其中一个关键争议点在于:多智能体到底该不该建?Anthropic 的《How we built our multi-agent research system》、Cogniti

超级智慧的黎明已至:Sam Altman的宣告,为何是现在必须读懂的未来?

您是否曾经想像过一个未来,AI 的能力将远远超越人类的智慧?过去这听起来像是科幻小说情节,但OpenAI的执行长Sam Altman 宣告,我们早已身处于「超级智慧」 (Superintelligence )时代的开端。

Nature研究遭质疑:像人类一样思考的AI,竟有点“荒谬”?

人工智能(AI),如果可以像人类一样“思考”,或许能够帮助我们理解人类的思维方式,尤其是不同心理状态(如抑郁或焦虑)的人群如何做出决策,进而为人类健康研究提供一个新视角。如今,一篇发表在权威科学期刊 Nature 上的研究论文,为实现上述