AI真的需要「像人类」那样思考吗?AlphaOne揭示属于大模型的「思考之道」

「The most effortful forms of slow thinking are those that require you to think fast.」 ——Daniel Kahneman,Thinking,Fast a

28岁辍学生掌舵Meta超级AI!小扎掷千亿,与奥特曼密谋,新「王」登顶

Alexandr Wang的人生堪称AI时代的缩影,19岁辍学到28岁掌管Meta超级智能。在最近的一场专访中,他谈到了AI的潜力与缺陷,他将如何影响这场智能革命的方向?19岁MIT辍学,24岁白手起家的亿万富翁,扎克伯格为他豪掷143亿

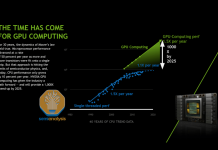

NVIDIA Tensor Core 的演变:从 Volta 到 Blackwell

https://semianalysis.com/2025/06/23/nvidia-tensor-core-evolution-from-volta-to-blackwell/在我们去年 AI Scaling Laws article

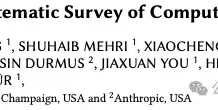

AI已学会PUA!Anthropic「说服」调查

这是一篇来自伊利诺伊大学香槟分校联合Anthropic发布的重磅报告,系统性地梳理了"计算说服"这个新兴领域。您可能会好奇"计算说服"是什么?传统人际说服基于理论构建(如亚里士多德的修辞学 、西奥迪尼的说服六原则 )和人类参与的实验。完全

LLM进入「拖拽时代」!只靠Prompt,几秒定制一个大模型,效率飙升12000倍

现在的大模型基本都具备零样本泛化能力,但要在真实场景中做特定的适配,还是得花好几个小时来对模型进行微调。即便是像LoRA这样的参数高效方法,也只能缓解而不能消除每个任务所需的微调成本。刚刚,包括尤洋教授在内的来自新加坡国立大学、得克萨斯大

强化学习新发现:无需数学样本,仅游戏训练AI推理大增

最近,强化学习领域出现了一个颠覆性发现:研究人员不再需要大量数学训练样本,仅仅让 AI 玩简单游戏,就能显著提升其数学推理能力。此前已有研究发现,即使不提供标准答案,仅用数学问题进行强化学习也能提高模型性能,这让人们开始重新思考强化学习的

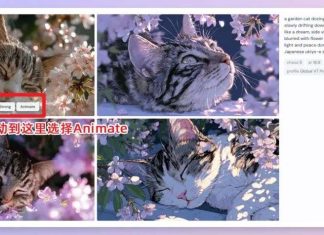

ACL 2025 | 让小说角色 「活」起来!复旦BookWorld打造沉浸式小说世界模拟系统

想象为《红楼梦》或《权力的游戏》创造一个AI的世界。书中的角色们变成AI,活在BookWorld当中。每天,他/她们醒来,思考,彼此对话、互动,建立感情和关系。如果他们能活出自己的生活,不再由笔者操控,故事是否会不一样?会不会有一个平行时

一文读懂深度表格数据表示学习 | 南京大学

在AI应用中,表格数据的重要性愈发凸显,广泛应用于金融、医疗健康、教育、推荐系统及科学研究领域。深度神经网络(DNN)凭借其强大的表示学习能力,在表格数据建模上展现出令人瞩目的潜力。南京大学团队系统介绍了表格表示学习这一研究领域,他们将现

多智能体到底该不该建?Anthropic、Cognition 与 LangChain 的三种解法

大模型驱动的 AI 智能体(Agent)架构最近讨论的很激烈,其中一个关键争议点在于:多智能体到底该不该建?Anthropic 的《How we built our multi-agent research system》、Cogniti

Cache Me If You Can:陈丹琦团队如何「抓住」关键缓存,解放LLM内存?

普林斯顿大学计算机科学系助理教授陈丹琦团队又有了新论文了。近期,诸如「长思维链」等技术的兴起,带来了需要模型生成数万个 token 的全新工作负载。大多数语言模型都基于 Transformer 架构,其在进行自回归解码(即逐字生成文本)时