AI智能体开发指南(2025版)

一位肉身行为体对人工智能体的独家指南编者按:2025年是智能体之年。本文从理论到实践对AI智能体开发进行了全面介绍,为你从外行变成专家提供了完整指南。文章来自编译。学习用n8n创建低代码AI智能体,实现工作自动化。我们再也掌控不了机器了。

新范式来了!新能量模型打破Transformer++扩展上限,训练扩展率快35%

是否可以在不依赖额外监督的前提下,仅通过无监督学习让模型学会思考? 答案有了。在心理学领域,人类思维通常被划分为两种不同类型:系统 1(快速思维)和系统 2(慢速思维)。当面对复杂问题如数学运算、多步骤推理等任务时,系统 2 思维(Sys

Stream-Omni:同时支持各种模态组合交互的文本-视觉-语音多模态大模型

GPT-4o式的多模态大模型(LMMs)展现出在文本、视觉和语音模态上的全能能力,其在线语音服务还能在语音交互过程中同步提供中间文本结果(即用户输入和模型响应的转录内容),为用户提供“边看边听”的灵活交互体验。因此,如何构建支持文本、视觉

重塑AI记忆边界:MemOS开源!时序推理较OpenAI提升159%

大模型记忆管理和优化框架是当前各大厂商争相优化的热点方向,MemOS 相比现有 OpenAI 的全局记忆在大模型记忆评测集上呈现出显著的提升,平均准确性提升超过 38.97%,Tokens 的开销进一步降低 60.95%,一举登顶记忆管理

用子模优化法为DeepResearch生成多样性查询

在开发DeepResearch时,生成多样化的查询 (query) 是一个关键细节。我们在开发时会在至少两处遇到这个问题。第一处是在解析用户的原始输入,并生成网页搜索查询,因为直接把原始输入抛给搜索引擎,效果往往不尽人意。第二处,是许多

伯克利最强代码Agent屠榜SWE-Bench!用Scaling RL打造,配方全公开

新晋AI编程冠军DeepSWE来了!仅通过纯强化学习拿下基准测试59%的准确率,凭啥?7大算法细节首次全公开。AI编程领域竞争激烈,但多被闭源模型主导。如今,一款开源软件工程模型DeepSWE横空出世,以59%的准确率大幅刷新了SOTA。

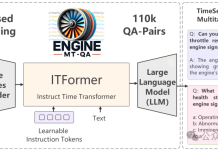

航空发动机用上大模型:解决复杂时序问题,性能超越ChatGPT-4o实现SOTA|上交创智复旦

时序数据分析在工业监控、医疗诊断等领域至关重要。比如航空发动机监控这个复杂工业场景中,工程师需分析海量多通道传感器数据,以判断设备状态并制定维护决策。然而,现有研究多聚焦于分类、预测等单一任务,与实际工业场景中专家通过自然语言进行复杂交互

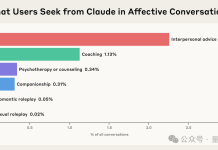

Anthropic最新研究:Claude正悄悄进化为“情绪价值大师”

你有没有试过,深夜心情低落时,对着AI倾诉?Anthropic最新研究发现,越来越多成年人正把AI当作情感陪伴。而Claude,正在悄悄成为那个“温柔倾听”的存在。△Claude中不同情感类互动类型及其占比研究显示,人们在面临更深层次的情

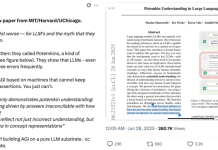

苹果一口咬死AI不会思考!OpenAI前高管直接开怼:AGI已来,别再酸了

最近,苹果的一篇论文掀起波澜,挑战了当下AI推理能力的基本假设。而OpenAI的前研究主管则断言:AGI时代已近在眼前。谁是谁非?AGI还有多远?最近,苹果发布了一篇论文,引发了关于AI是否真正在推理的激烈讨论。它提出了一个尖锐问题:当前

Gary Marcus惊世之言:纯LLM上构建AGI彻底没了希望!MIT、芝大、哈佛论文火了

今天,著名的人工智能学者和认知科学家 Gary Marcus 转推了 MIT、芝加哥大学、哈佛大学合著的一篇爆炸性论文,称「对于 LLM 及其所谓能理解和推理的神话来说,情况变得更糟了 —— 而且是糟糕得多。」这项研究揭示了一种被称为「波