DPO与GRPO谁更胜一筹?港中文、北大等联合发布首个系统性对比研究

近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。如今,这股 RL 的浪潮也涌向了图像生成领域。当

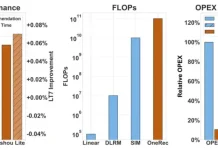

推荐大模型来了?OneRec论文解读:端到端训练如何同时吃掉效果与成本

人人都绕不开的推荐系统,如今正被注入新的 AI 动能。随着 AI 领域掀起一场由大型语言模型(LLM)引领的生成式革命,它们凭借着强大的端到端学习能力、海量数据理解能力以及前所未有的内容生成潜力,开始重塑各领域的传统技术栈。作为互联网流量

Agent全自动搭建代码运行环境,实时更新解决评测过拟合/数据污染问题|微软

长期以来主流的代码修复评测基准SWE-bench面临数据过时、覆盖面窄、手动维护成本高等问题,严重制约了AI模型真实能力的展现。微软发布全新代码修复评测基准SWE-bench-Live,不仅引入了来自GitHub最新的Issue,显著提升

李飞飞团队提出架构设计新思路!无需从头训练,直接“嫁接”预训练模型关键组件

预训练模型能否作为探索新架构设计的“底座” ?最新答案是:yes!简单来说,按照研究人员设计好的架构方案从头训练模型,往往是检验一个架构是否有效的重要手段。但问题在于,从头训练模型的成本也太高了!对此,包括李飞飞团队在内的研究人员提出了一

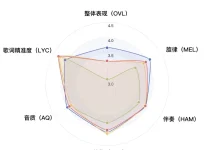

人人皆可创作音乐!腾讯AI Lab开源音乐生成大模型SongGeneration

6 月 16 日,腾讯 AI Lab 推出并开源 SongGeneration 音乐生成大模型,专注解决音乐 AIGC 中音质、音乐性与生成速度这三大共性难题,基于 LLM-DiT 的融合架构,模型在保持生成速度的同时,显著提升了音质表现

国产SOTA新模型精准get“画(3+6)条命的动物” | 开源

生成图像这件事,会推理的AI才是好AI。举个例子,以往要是给AI一句这样的Prompt:(3+6)条命的动物。我们人类肯定一眼就知道是猫咪,但AI的思考过程却是这样的:△虽然生成了猫,但思考过程不对思考的过程还是把“(3+6)”里的数字分